- В понеделник Nvidia представи H200, графичен процесор, предназначен да обучава и внедрява типовете AI модели, които захранват генеративния бум на AI.

- H200 включва 141 GB памет от следващо поколение „HBM3“, която ще му помогне да генерира текст, изображения или прогнози с помощта на AI модели.

- Интересът към базираните на AI графични процесори на Nvidia подхрани инерцията на компанията, като се очаква продажбите да нараснат със 170% през това тримесечие.

Дженсън Хуанг, президент на Nvidia, държи процесора Grace hopper чип, използван в генеративния AI на основната презентация на Supermicro по време на Computex 2023.

Уалид Баразек | Rocket Lite | Getty Images

В понеделник Nvidia представи H200, графичен процесор, предназначен да обучава и внедрява типовете AI модели, които захранват генеративния бум на AI.

Новият графичен процесор е надстройка от H100, чипът, който OpenAI използва, за да обучи своя най-напреднал голям езиков модел, GPT-4. Големи компании, стартиращи фирми и правителствени агенции се конкурират за ограничени доставки на чипове.

Чиповете H100 струват между 25 000 и 40 000 долара, изчислява Реймънд Джеймс, и са необходими хиляди от тях, за да работят заедно, за да създадат най-големите модели в процес, наречен „обучение“.

Вълнението около графичните процесори на Nvidia, захранвани с изкуствен интелект, доведе до скок на акциите на компанията, които са нараснали с повече от 230% досега през 2023 г. Nvidia очаква приходи от около $16 милиарда за третото фискално тримесечие, което е ръст от 170% спрямо миналата година.

Основното подобрение в H200 е, че той включва 141 GB памет от следващо поколение „HBM3“, която ще помогне на чипа да изпълнява „евристики“ или да използва голям модел, след като е бил обучен да генерира текст, изображения или прогнози.

Nvidia каза, че H200 ще генерира изход почти два пъти по-бързо от H100. Това се основава на тестване с Llama 2 на Meta.

H200, който се очаква да бъде доставен през второто тримесечие на 2024 г., ще се конкурира с MI300X GPU на AMD. Чипът на AMD, подобно на H200, има допълнителна памет в сравнение с предшествениците си, което помага на големите модели да се поберат на хардуера, за да изпълняват изводи.

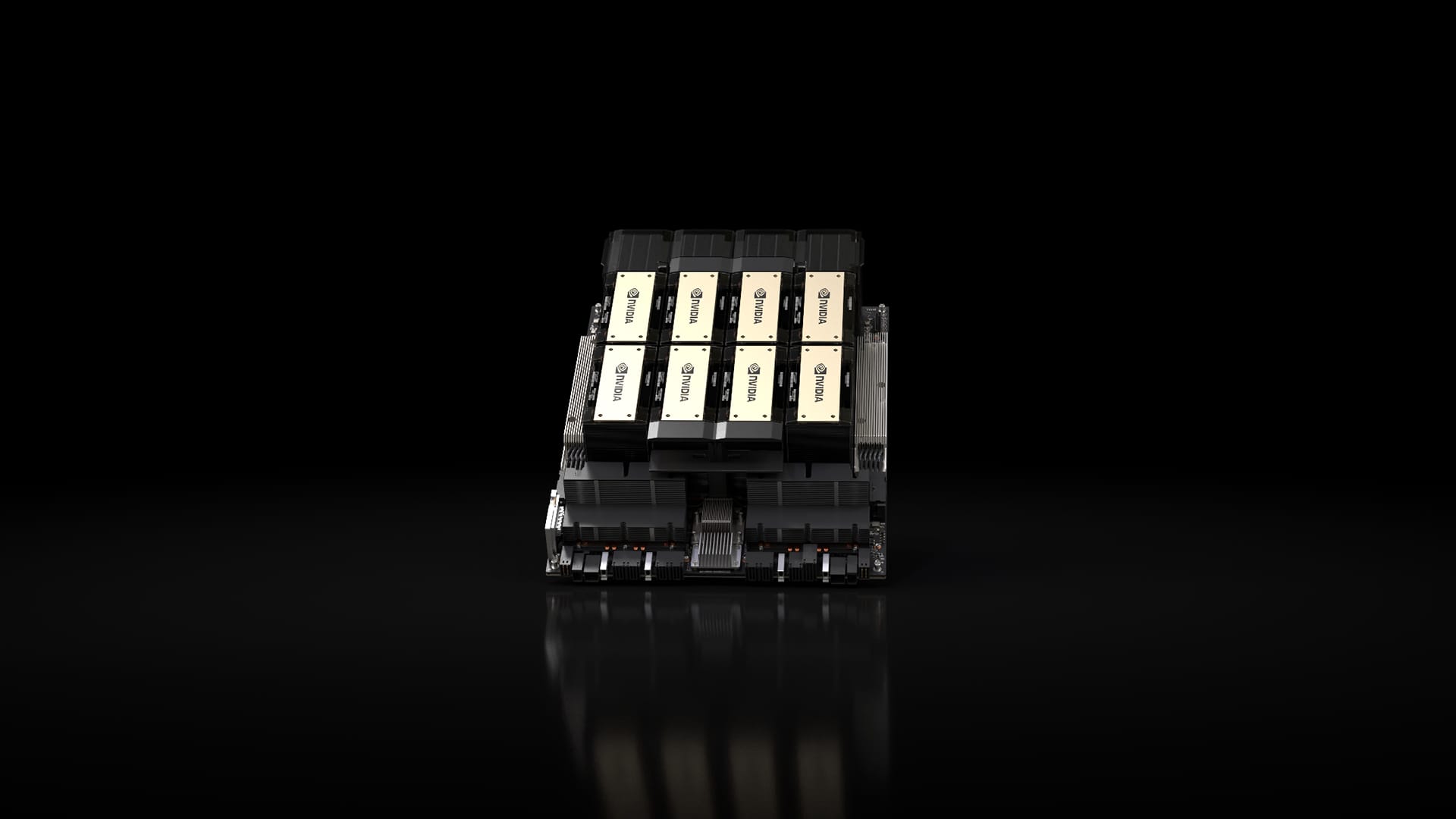

Чипсет Nvidia H200 в система Nvidia HGX с осем GPU.

Nvidia

Nvidia каза, че H200 ще бъде съвместим с H100, което означава, че компаниите с изкуствен интелект, които вече се обучават на предишния модел, няма да трябва да променят своите сървърни системи или софтуер, за да използват новата версия.

Nvidia казва, че ще се предлага в сървърни конфигурации с четири или осем GPU на пълните HGX системи на компанията, както и в чип, наречен GH200, който свързва H200 GPU с базиран на Arm процесор.

Въпреки това, H200 може да не държи короната за най-бърз AI чип на Nvidia за дълго.

Докато компании като Nvidia предлагат много различни конфигурации на своите чипове, новите полупроводници често правят голяма крачка напред на всеки две години, когато производителите преминат към различна архитектура, която отключва по-значителни печалби в производителността, отколкото добавянето на памет или други по-малки подобрения. H100 и H200 са базирани на Hopper архитектурата на Nvidia.

През октомври Nvidia каза на инвеститорите, че ще премине от двугодишен архитектурен ритъм към едногодишен модел на пускане поради голямото търсене на нейните графични процесори. Фирмата предложи Слайд предлага Той ще обяви и пусне своя чип B100, базиран на предстоящата архитектура Blackwell, през 2024 г.

Той наблюдава: Ние силно вярваме в тенденцията на AI, която ще нарасне през следващата година

Не пропускайте тези истории от CNBC PRO:

„Тотален фен на Twitter. Нежно очарователен почитател на бекона. Сертифициран специалист по интернет.“

More Stories

Nasdaq и S&P 500 водят до спад пред разочароващите печалби на Nvidia

MTA и полицията на Ню Йорк започват репресии срещу автобусните маршрути заради „откровено“ укриване на таксите

Българският министър на земеделието участва в Международния форум за биологично земеделие в Словения